Vì sao kỹ năng nhân rộng học máy là xu thế tương lai

Sau khi bạn đã nắm được cách hoạt động của một mô hình học máy thì bước tiếp theo bạn có thể băn khoăn rằng làm sao để đưa những mô hình này đến tới tay của người dùng. Một trong những vấn đề nóng hổi gần đây đó là chi phí rất tốn kém để triển khai các hạ tầng AI.

Theo tờ futurism:

The Information's latest figure is roughly in line with Fortune's reporting in January that revealed the breakdown of the company's 2022 expenses, which totaled $544.5 million: "$416.45 million on computing and data, $89.31 million on staff, and $38.75 million in unspecified other operating expenses."

ChatGPT đã tiêu tốn hơn $544.5 triệu đô trong năm 2022 và $416.45 triệu đô trong đó - tức gần 80% chi phí là dành cho hạ tầng tính toán. Team ProtonX đã có bài dự đoán về hạ tầng cần triển khai cho ChatGPT ở đây.

Cho nên bạn có thể thấy rào cản để có thể đưa trí tuệ nhân tạo ra với người dùng liên quan rất nhiều đến hạ tầng. Vì thế trong những năm tiếp theo tới đây, nhu cầu về đội ngũ kỹ sư có khả năng tối ưu, cắt giảm chi phí triển khai sẽ là ưu tiên hàng đầu của các công ty có sản phẩm AI.

Để có thể tối ưu được mô hình và nhân rộng thì kỹ sư sẽ cần phải tập trung vào 2 kỹ năng sau đây:

1) Kỹ năng tối ưu mô hình

Có rất nhiều phương pháp tối ưu mô hình nhưng hai phương pháp qua nhiều lần thực nghiệm cũng như trao đổi với nhiều kỹ sư trong và ngoài nước thì hai phương pháp thường xuyên được sử dụng

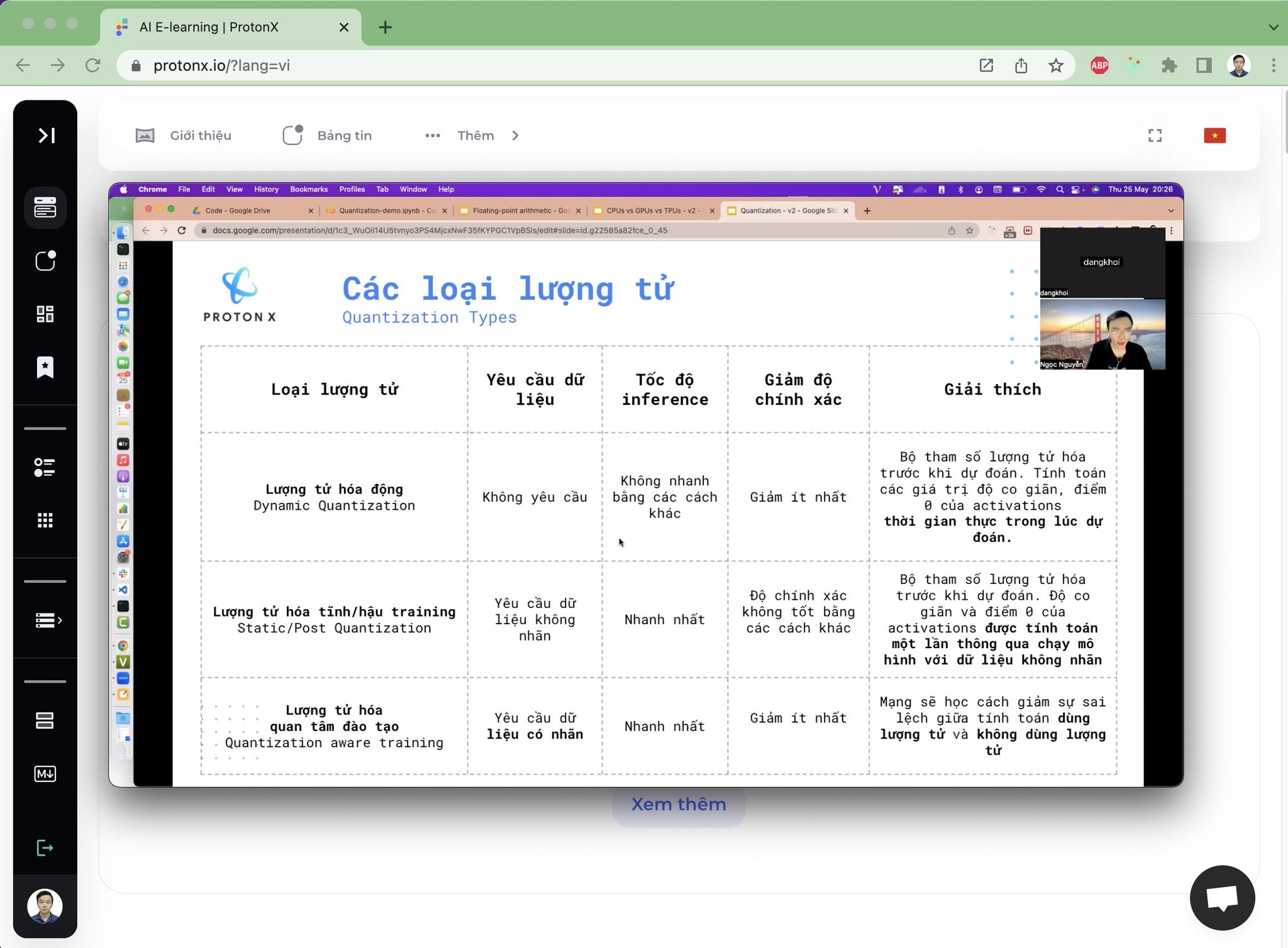

Lượng tử hóa mô hình: Lượng tử hóa mô hình là phương pháp lưu trữ mô hình ở dạng lưu trữ thấp hơn. Một ví dụ đơn giản bạn có thể hình dung, mô hình thông thường có rất nhiều tham số. Một tham số tức là một số ví dụ số

3.141592653589793238462643383279502884197sẽ được lưu trữ bằng 32 bit - hay Float32. Nhưng giờ chúng ta sẽ đánh đổi chính xác bằng việc dùng số bit nhỏ hơn để lưu trữ và giờ đây con số này chỉ còn3.1415926535897932384. Đây chính là lượng tử hóa. Việc làm này có:Ưu điểm: Giúp việc lưu trữ tính toán mô hình giảm đi một nửa, tức là bạn hình dung tính toán sẽ nhanh gấp đôi trong khi lưu trữ giảm đi còn một nửa

Nhược điểm: Nhược điểm chí mạng có phương pháp này đó là mô hình cũng mất đi độ chính xác. Nên trong thực tế sẽ không sử dụng lượng tử hóa đơn thuần mà sẽ sử dụng lượng tử hóa quan tâm đào tạo (Quantization Aware Training), tức là chúng ta sẽ cho mô hình học để tối ưu theo sự sai lệch của lượng tử hóa. Ví dụ bài toán phân loại thông thường có giá trị mất mát theo Cross Entropy thì giờ chúng ta bổ sung thêm vào giá trị mất mát này sự sai lệch của việc lượng tử. Bằng việc làm như vậy mô hình sẽ quan tâm đến sai lệch khi lượng tử và cố gắng cập nhật các giá trị tham số để giảm nhẹ nó.

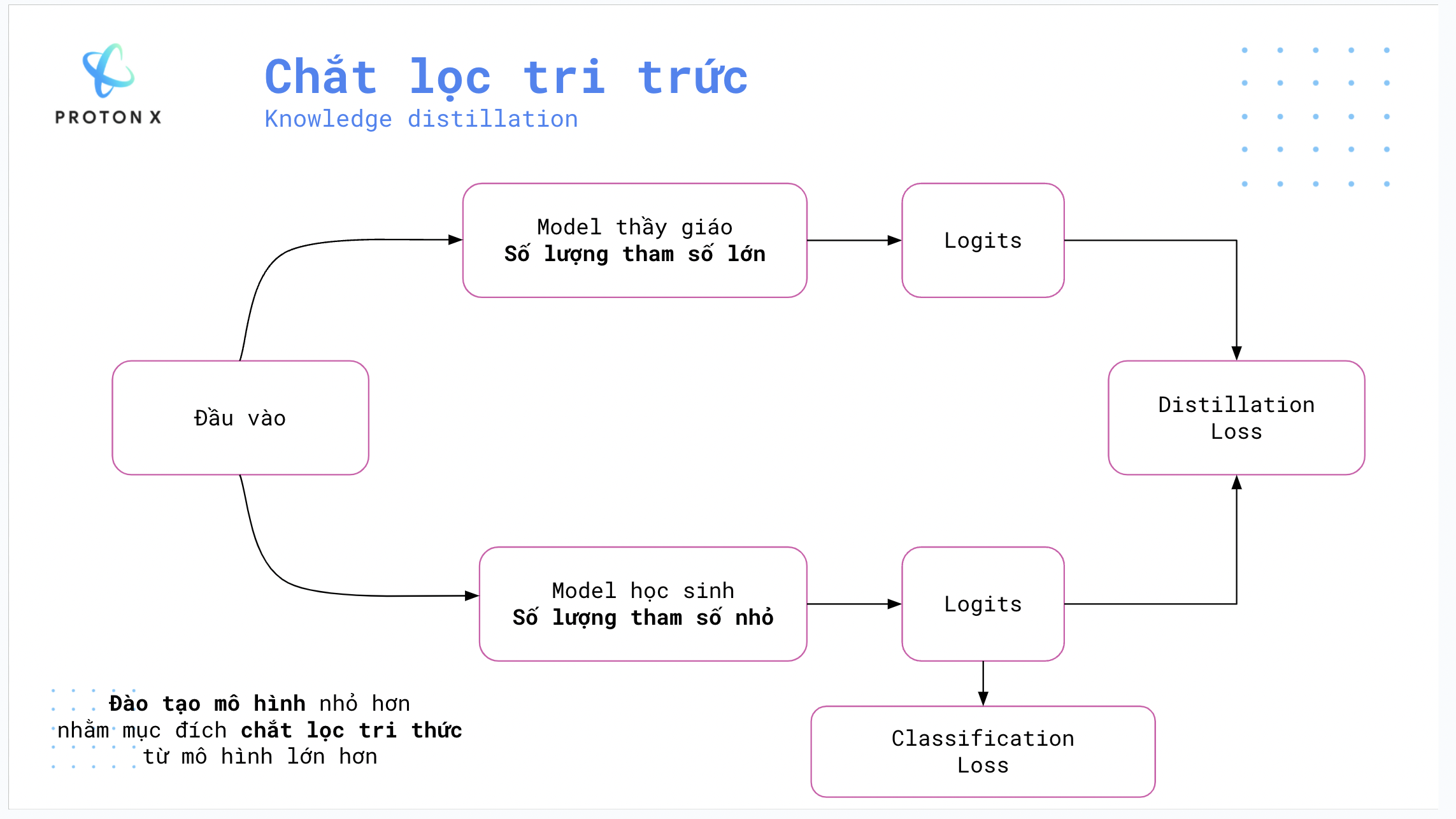

Chắt lọc tri thức mô hình:

Một miêu tả dễ hình dung về chắt lọc tri thức đó là chúng ta sẽ tạo ra một mô hình nhỏ hơn mô hình chúng ta muốn tối ưu và mô hình này có mục tiêu sẽ tạo ra những kết quả gần giống nhất với mô hình ban đầu. Ví dụ liên tưởng đơn giản ở lớp học MLEs của ProtonX - Giống như việc gia sư 1-1 vậy, học trò sẽ cố gắng bắt trước theo thầy giáo và cố gắng chắt lọc tri thức của thầy. Đây là một trong những phương pháp có tính ứng dụng thực tế cao trong thực tế.

2) Kỹ năng triển khai mô hình trên sản phẩm thực tế

Để triển khai trên sản phẩm thực tế bạn cần hiểu các phần cứng dành cho học máy bao gồm

CPU: phần cứng thông dùng trên máy tính chúng ta sử dụng hàng ngày

GPU: Card đồ họa xử lý tính toán song song đa luồng

TPU: Thiết bị tính toán song song chuyên dùng để tính toán học sâu

Bạn có thể xem chi tiết phân biệt 3 phần cứng này tại đây

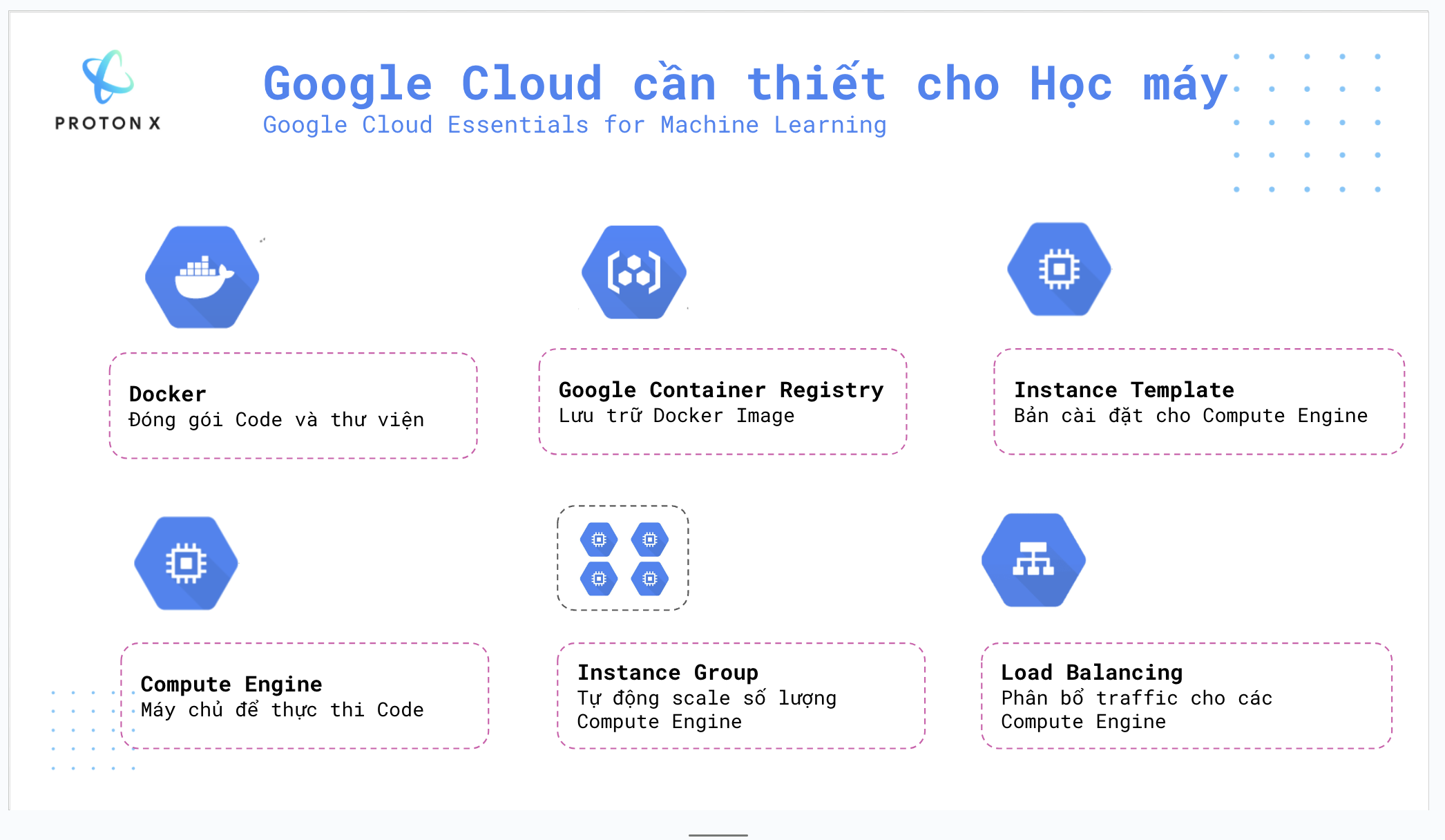

Khi đã nắm được đặc điểm của các phần cứng này rồi thì một trong những công cụ để nhân rộng các phần cứng này đó sẽ chính là Điện toán đám mây (Cloud). Điện toán đám mây cung cấp các dịch vụ công nghệ bao gồm tính toán, cơ sở dữ liệu, kết nối, phần mềm thông qua internet. Những lý do quan trọng để sử dụng Cloud:

Tuy nhiên Cloud rất rộng nên với học máy thì chúng ta cần nắm được một số khái niệm và sử dụng thành thục chúng:

Thay vì tự phải xây dựng toàn bộ kiến trúc hạ tầng, Cloud cung cấp các dịch vụ giúp bạn triển khai các server vật lý nhanh chóng dễ dàng thông qua lập trình. Hai khái niệm quan trọng về nhân rộng bạn cần nắm chắc:

Instance Group: Nhóm nhiều server vật lý

Load Balancing: Cân bằng tải truy cập giữa các server

Hai khái niệm này đều có trong tất cả các dịch vụ Cloud lớn và là khái niệm cốt lõi để bạn có thể scale mô hình của mình.

Vậy là trên đây ProtonX đã trình bày cho bạn hai kỹ năng quan trọng trong việc tối ưu và nhân rộng mô hình học máy của mình. Hi vọng hữu ích với công việc AI của bạn.

Bạn có thể học được tất cả các công nghệ này thông qua lớp học Scale Machine Learning System của ProtonX. Tham khảo thêm tại đây.

Chúc bạn một ngày tràn đầy năng lượng.

Trân trọng,